突破黑夜视野局限!东南大学紧凑型超构相机:120°超广角+智能算法,让暗区细节“显形”

深夜的城市道路上,自动驾驶汽车的摄像头正面临两难:车灯强光让近处画面惨白过曝,人行道阴影里却连行人轮廓都模糊不清;高空的微型侦察无人机想覆盖更广区域,传统广角镜头的bulky体积又成了“卡脖子”的难题。这两个场景指向同一个技术痛点——如何在紧凑设备中,同时实现广角视野与低光清晰成像?如今,东南大学与紫金山实验室的陈绩教授、张在琛研究团队,用一款“软硬件协同”的紧凑型超构相机,给出了令人眼前一亮的解决方案。

痛点:超构透镜的“广角暗区困境”

超构透镜本是解决“镜头小型化”的利器——它薄如平面,无需传统广角镜头的多片曲面透镜堆叠,能大幅压缩设备体积。但它有个绕不开的物理瓶颈:大角度入射光强衰减。

简单说,当光线斜着进入超构透镜(比如画面边缘区域),有效通光面积会像“余弦函数”一样急剧缩小,导致画面边缘像被“按了暗键”,亮度断崖式下跌;再遇上夜间非均匀光照(如路灯、车灯),亮区过曝、暗区失细节的问题会更严重——要么提亮暗区却让噪点爆炸,要么压制亮区却让边缘更暗,始终难以兼顾。

破局:“分而治之”的硬件+“逐像素精修”的软件

团队没有孤立解决某一个问题,而是打造了“硬件筑基+软件升维”的全链路方案,相当于给超构相机装上了“精准分工的眼睛”和“智能修图的大脑”。

硬件:三个超构透镜,拼出120°超广角

传统超构透镜试图用“单个镜片扛下所有视场”,结果顾此失彼。团队反其道而行之,设计了线性排列的三合一超构透镜阵列,让每个镜片“各司其职”:

左侧透镜:负责捕捉60°~20°的左半视野;

中间透镜:聚焦20°~+20°的中心视野(通过相位优化保证清晰度);

右侧透镜:覆盖+20°~+60°的右半视野(叠加倾斜相位适配大角度光线)。

三个镜片捕捉的子图像无缝拼接后,就能得到完整的120°水平超广角画面,既保留了超构透镜的紧凑性,又避免了单个镜片的“边缘暗化”问题。

软件:MetaLightEnhance算法,让暗区“显形”

硬件解决了“看得宽”,软件则要解决“看得清”——尤其是夜间复杂光照场景。团队开发的MetaLightEnhance智能算法,不是简单的“全局提亮”,而是像经验丰富的后期大师一样“逐像素精修”。

它的核心逻辑是“迭代增强”:

1.初始曲线:先用三阶多项式曲线打下基础,确定亮度调整的大致方向;

2.智能参数图:通过一个叫“MLEN”的深度神经网络(类似UNet结构,还加了小波变换模块),为每帧图像生成专属“参数图”——这个图能精准识别哪里是亮区、哪里是暗区,甚至能区分“车灯强光”和“行人轮廓”;

3.迭代优化:把上一轮处理的图像当输入,重复“生成参数调整亮度”的过程,实验证明迭代6次效果最佳——既能把暗区的行人、自行车轮廓“拉亮”,又不会让亮区的车牌、车灯过曝。

小波变换模块是关键“加分项”:它能捕捉图像不同尺度的细节,比如远处卡车的轮廓(低频信息)和近处路面的纹理(高频信息),让算法调整时更“有针对性”,不会把噪点误当成细节提亮。

实测:从白昼到黑夜,画质碾压传统方案

团队用实验数据证明了技术实力,无论是正常光照还是极端黑夜,这款超构相机的表现都远超传统方式。

白昼场景:边缘亮度“逆袭”

未处理的超构相机图像,边缘区域明显偏暗;经过MetaLightEnhance算法优化后,整个画面亮度分布均匀,灰度直方图更接近真实场景——比如远处的建筑轮廓、近处的路面纹理,都能清晰呈现。

夜间场景:暗区细节“不丢失”

原始图像:暗区(人行道、远处车辆)完全“隐身”,只有车灯附近可见;

简单增曝:暗区是亮了,但噪点爆炸,车灯区域惨白一片,车牌信息全丢;

算法增强:暗区的行人、自行车轮廓清晰可见,亮区的车牌数字也能辨认,动态范围和信噪比大幅提升。

更关键的是量化数据:在衡量图像质量的PSNR(峰值信噪比)和SSIM(结构相似性)指标上,MetaLightEnhance算法表现最佳——PSNR达14.41(远超简单增曝的7.47),SSIM达0.69(是原始图像的2倍多)。把处理后的图像输入YOLO目标检测网络,漏检、误检率也大幅下降,能准确识别汽车、行人、自行车等关键目标。

未来:从“看得宽”到“看得全”,还有这些新可能

这项技术最核心的价值,在于它对“尺寸、重量、功耗(SWaP)”的极致优化——这让它在微型设备中极具潜力:比如可穿戴智能眼镜(需要广角低光视野)、微型无人机(体积受限但要覆盖广域)、紧凑型车载传感器(装在车侧不占空间)。

但科研团队也提出了三个值得探索的方向,未来或许会有更大突破:

1.从1D到2D:目前120°是水平视场,垂直视场只有40°。如果把线性阵列改成2D阵列,怎么在保持紧凑的同时,实现“水平+垂直”双广角?

2.从单色到彩色:现在的相机只能拍黑白画面,要实现全彩,是叠多层超构透镜(对应RGB三色),还是靠算法“补色”?哪种方案更省体积、更少噪点?

3.软硬件边界:全黑环境下,算法什么时候会“失灵”?届时是不是得换更灵敏的传感器(比如SPAD传感器)?软硬件的“协作极限”在哪里?

超构光学+计算成像,打开未来“视界”

东南大学的这款超构相机,不只是一次“镜头升级”,更是超构光学与计算成像结合的典范。它没有回避物理规律的限制,而是用“硬件分工+软件智能”的思路,打破了“广角就难低光,紧凑就丢细节”的固有印象。

未来,当这项技术解决了全彩、2D广角的问题,我们或许能看到:智能眼镜能在深夜看清拐角的行人,微型机器人能在昏暗管道里看清全貌,自动驾驶汽车的“peripheralvision”(周边视野)不再有暗区盲区。而这些突破,或许就藏在科研团队下一次的实验室创新里。

-

半导体抛光设备自动化应用及工艺质量管控要点探析

在半导体器件规模化量产进程中,抛光工艺作为保障晶圆加工精度与表面质量的核心环节,其设备自动化水平、工艺参数调控能力、检测体系完善度及异常处置效率,直接决定生产效率、工艺稳定性与产品良率。本文从抛光设备自动化配置要求、核心工艺参数调控、关键检测指标界定及常见工艺异常处理四个维度,系统阐述半导体抛光工艺的质量管控核心要点,为半导体抛光制程的标准化、精细化实施提供参考。

2026-02-12

-

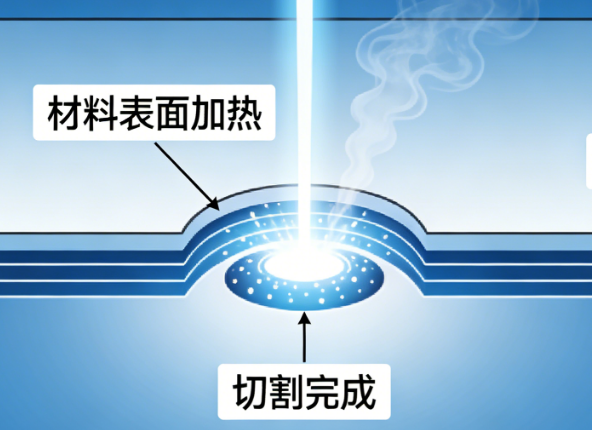

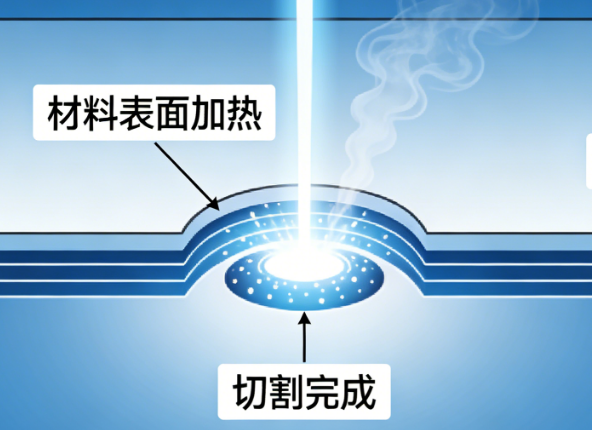

硅晶圆激光切割核心技术深度解析:原理、工艺与质量把控

在半导体制造产业链中,硅晶圆切割是芯片成型的关键工序,其加工精度与效率直接影响芯片良品率和产业发展节奏。随着微电子器件向微型化、薄型化升级,传统切割方式的弊端逐渐显现,激光切割凭借高精度、低损伤的技术优势成为行业主流。本文从激光切割系统的硬件构成出发,深入拆解隐形切割与消融切割两大核心工艺,解析光斑、焦点的精度控制逻辑,并探讨切割质量的评价维度与效率平衡策略,系统梳理硅晶圆激光切割的核心技术体系

2026-02-12

-

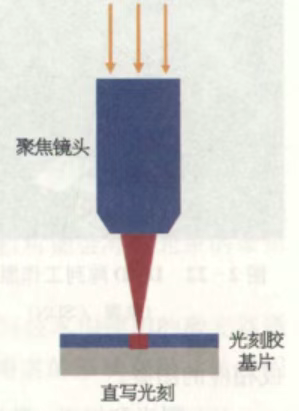

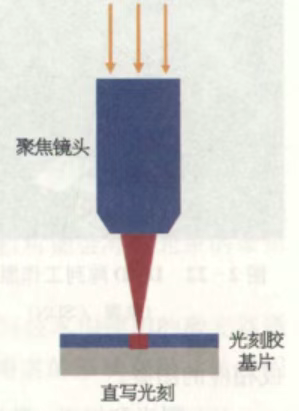

无掩模激光直写技术研究概述

无掩模激光直写技术作为微纳加工领域的先进光刻技术,摒弃了传统光刻工艺对掩模版的依赖,凭借直接写入的核心特性,在复杂微纳结构制备、高精度图案加工中展现出独特优势,成为微纳加工领域的重要技术方向。本文从工作原理与流程、技术特性、现存挑战、分辨率与对准参数、核心设备及厂务动力配套要求等方面,对该技术进行全面梳理与阐述。

2026-02-12

-

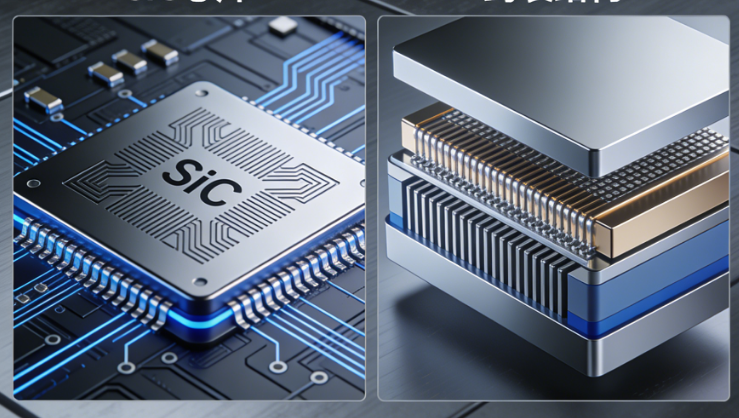

SiC功率器件的高温时代:封装成为行业发展核心瓶颈

在半导体功率器件技术迭代进程中,碳化硅(SiC)凭借高温工作、高电流密度、高频开关的核心优势,成为推动功率半导体升级的关键方向,其普及大幅提升了器件的功率密度与工作效率,为功率半导体行业发展带来全新机遇。但与此同时,行业发展的核心瓶颈正悄然从芯片设计与制造环节,转移至封装层面。当SiC将功率器件的工作温度与功率密度不断推高,芯片本身已具备承受更高应力的能力,而封装环节的材料适配、热路径设计等问题却日益凸显,高温与快速功率循环叠加的工况下,焊料与热路径成为决定SiC功率模块寿命的核心因素,封装技术的发展水平,正成为制约SiC功率器件产业化落地与长期可靠应用的关键。

2026-02-12