光计算加速器能否突破当前算力瓶颈?光计算加速器原理、应用与挑战解析

在人工智能与科学计算快速演进的当下,算力需求正呈指数级增长态势。当电子芯片逐步逼近物理极限,一场由光子技术引发的计算领域革新已悄然拉开帷幕。光计算加速器作为光学与计算科学深度融合的创新性技术,能否凭借其独特的物理属性,为当前算力困局提供突破性解决方案?本文将从技术原理、应用场景及发展挑战等维度展开系统性探讨。

一、电子计算架构的现实困境与光子技术的崛起逻辑

以GPU为代表的电子数字并行加速器,虽依托冯·诺依曼架构在通用计算领域取得显著成就,但在大规模并行计算场景中逐渐暴露出固有缺陷:随着半导体工艺进入3纳米以下节点,量子隧穿效应导致漏电流显著增加,短沟道效应引发载流子迁移率下降,电子器件的能效提升面临严峻物理限制;同时,晶体管电路能耗与时钟频率呈三次方关系,使得大规模数字电路的时延优化空间趋近于临界值。以GPT4训练为例,即便配置2.5万块NVIDIAA100GPU构建计算集群,仍需90100天方能完成训练任务,其能耗规模已成为行业发展的突出制约因素。

光子技术的兴起则为突破这一困局提供了新方向。光计算凭借两大核心物理优势,重构了计算逻辑框架:

带宽优势:光子器件带宽可达电子器件的10万倍量级,能够支持大容量频分复用并行计算模式。尽管小型电子模拟/数字电路可实现5GHz以上带宽指标,但实际计算系统受限于线延迟效应,运行速度往往远低于理论阈值,而光子器件动态响应速度已接近百GHz水平。

传输优势:硅基氮化硅波导在16001640nm波段的传输损耗仅为0.06dB/cm,几乎不存在焦耳热效应;相较之下,长距离电信号传输过程中,焦耳热效应与信号串扰问题显著,且能耗随传输距离呈线性增长态势。

二、光计算的核心技术原理:从光子调制到矩阵运算的实现路径

光计算加速器的底层技术逻辑,在于通过光信号的调制、检测及线性运算完成复杂计算任务。其核心功能单元——光学乘加(MAC)单元,构成了计算阵列的基础架构:

调制编码技术:光信号可通过光强调制、相位调制、光干涉及衍射元件等多种方式实现信息编码。例如,电光调制器(EOM)可通过电压信号动态改变光强,相位调制器则利用光波相位差特性完成信息加载。

检测转换机制:单端检测、双端检测、相干检测及阵列检测等技术,可实现光信号到电信号的高效转换。其中,阵列检测技术能够支持大规模并行数据采集,显著提升计算系统的实时处理能力。

并行计算架构:通过时分复用(TDM)、空分复用(SDM)、波分复用(WDM)及深度衍射神经网络(D2NN)等架构设计,光计算系统可实现多维度光信号的并行处理。基于TDM的光计算加速器能够在降低系统复杂度与成本的同时,有效减少电光调制器(EOM)的使用数量;SDM架构则是实现光计算高速并行化的基础方式之一,与其他复用策略结合后,可充分发挥光计算的高计算密度与低延迟特性,构建高效能计算系统。

三、应用场景拓展:人工智能与科学计算的双维度赋能

在人工智能领域,光计算加速器展现出颠覆性应用潜力。其大规模并行计算特性可显著提升模型训练与推理效率:在自然语言处理领域,光计算技术可快速完成Transformer架构中的注意力机制矩阵运算,将推理延迟降低至电子方案的千分之一量级;在计算机视觉领域,基于光卷积神经网络的目标检测模型,可借助光子的低延迟特性实现实时视频分析,其功耗仅为GPU方案的1/100。

科学计算领域同样受益于光计算技术的独特优势。对于以迭代算法为核心的计算问题(如数值模拟、量子化学计算等),光计算的低能耗与高带宽特性可大幅提升处理效率。基于逆向设计技术的超材料平台,能够在芯片级尺度高效求解微波频段的通用积分方程,为雷达仿真、电磁优化等场景提供实时计算支持。值得关注的是,大模型在4位精度下的训练可行性,为光学模拟计算开辟了应用新空间——其擅长的低精度、高速度计算特性,与人工智能及科学计算的部分核心需求高度契合。

四、技术挑战与商业化路径:从实验室到产业应用的关键跨越

尽管光计算技术前景广阔,但其产业化进程仍面临多重技术挑战:光学器件的高精度控制问题(如纳米级波导加工误差)、光电混合系统的接口损耗、模拟计算过程中的误差累积效应等,均亟待突破。此外,如何实现光学计算阵列与现有电子系统的兼容性,构建“光电协同”的异构计算架构,成为商业化落地的核心命题。

突破上述挑战需依赖跨学科创新协同:新型光电子材料(如二维材料石墨烯、氮化硼)的研发,可显著提升器件集成度与响应速度;自适应模拟电路设计与算法优化(如稀疏矩阵光计算),能够进一步降低计算误差;而行业生态体系的构建(如开源光计算框架、标准接口协议),将加速技术从实验室向产业应用的转化进程。

五、未来展望:光子计算时代的发展蓝图

张江实验室等研究团队的探索实践表明,光计算加速器已从理论研究阶段迈入原型验证阶段。展望未来,随着架构创新与工艺技术的成熟,其有望在以下领域率先实现商业化突破:

边缘计算领域:在自动驾驶、智能终端等场景中,光计算的低功耗特性可有效延长设备续航时间,同时实现传感器数据的实时处理。

数据中心场景:光互联技术与计算单元的深度融合,将显著缓解数据中心的“内存墙”与“功耗墙”问题,为万亿参数级大模型的高效训练提供支撑。

专用计算领域:在金融风控(投资组合优化)、通信信号处理(非线性失真补偿)等特定领域,光计算的定制化架构将展现出碾压性效率优势。

当摩尔定律渐近发展瓶颈,光子技术正接过算力革命的接力棒。这场由光信号驱动的计算变革,不仅是技术层面的突破,更是对计算范式的重新定义。在可预见的未来,“硅基电子+光子计算”的异构计算时代或将到来,为智能计算领域开启全新的发展纪元。光计算加速器能否最终突破当前算力瓶颈,不仅取决于技术创新的速度,更依赖于跨学科协作与产业生态的协同演进。

-

半导体抛光设备自动化应用及工艺质量管控要点探析

在半导体器件规模化量产进程中,抛光工艺作为保障晶圆加工精度与表面质量的核心环节,其设备自动化水平、工艺参数调控能力、检测体系完善度及异常处置效率,直接决定生产效率、工艺稳定性与产品良率。本文从抛光设备自动化配置要求、核心工艺参数调控、关键检测指标界定及常见工艺异常处理四个维度,系统阐述半导体抛光工艺的质量管控核心要点,为半导体抛光制程的标准化、精细化实施提供参考。

2026-02-12

-

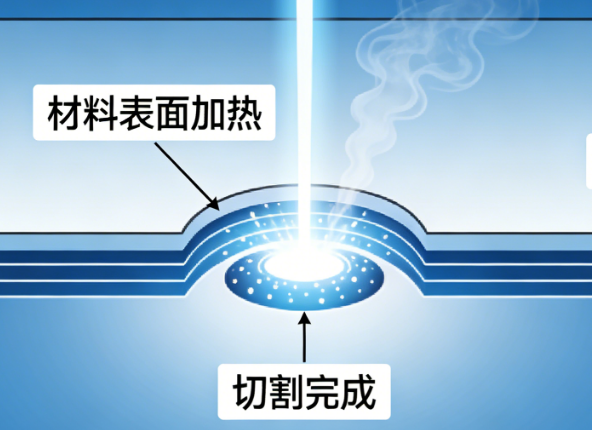

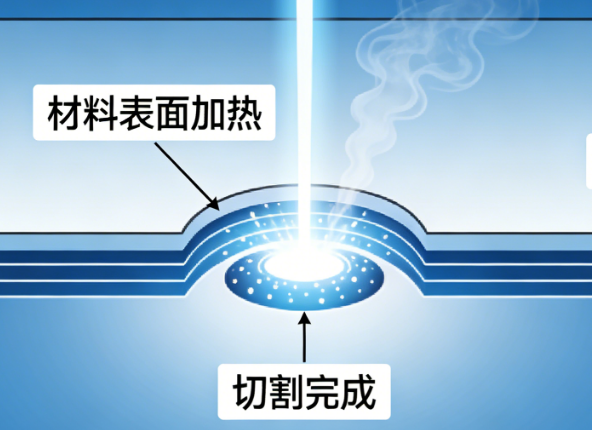

硅晶圆激光切割核心技术深度解析:原理、工艺与质量把控

在半导体制造产业链中,硅晶圆切割是芯片成型的关键工序,其加工精度与效率直接影响芯片良品率和产业发展节奏。随着微电子器件向微型化、薄型化升级,传统切割方式的弊端逐渐显现,激光切割凭借高精度、低损伤的技术优势成为行业主流。本文从激光切割系统的硬件构成出发,深入拆解隐形切割与消融切割两大核心工艺,解析光斑、焦点的精度控制逻辑,并探讨切割质量的评价维度与效率平衡策略,系统梳理硅晶圆激光切割的核心技术体系

2026-02-12

-

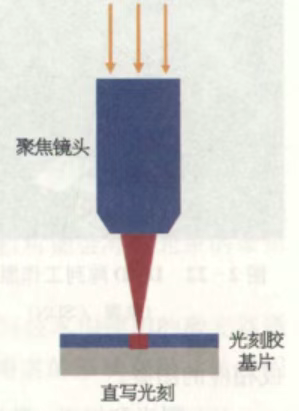

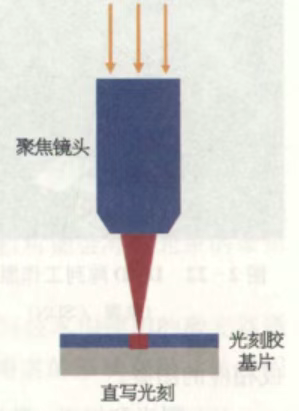

无掩模激光直写技术研究概述

无掩模激光直写技术作为微纳加工领域的先进光刻技术,摒弃了传统光刻工艺对掩模版的依赖,凭借直接写入的核心特性,在复杂微纳结构制备、高精度图案加工中展现出独特优势,成为微纳加工领域的重要技术方向。本文从工作原理与流程、技术特性、现存挑战、分辨率与对准参数、核心设备及厂务动力配套要求等方面,对该技术进行全面梳理与阐述。

2026-02-12

-

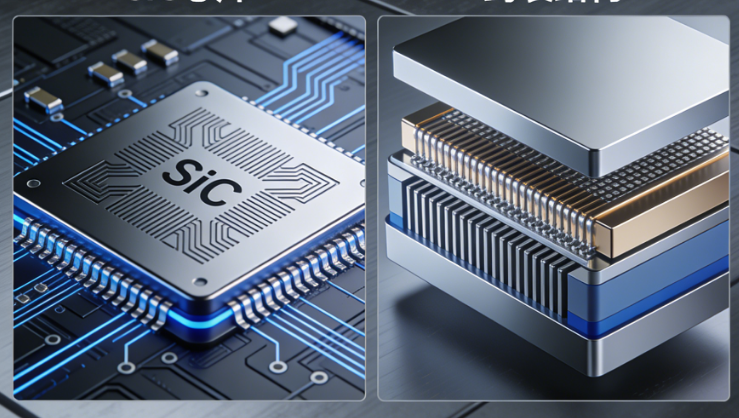

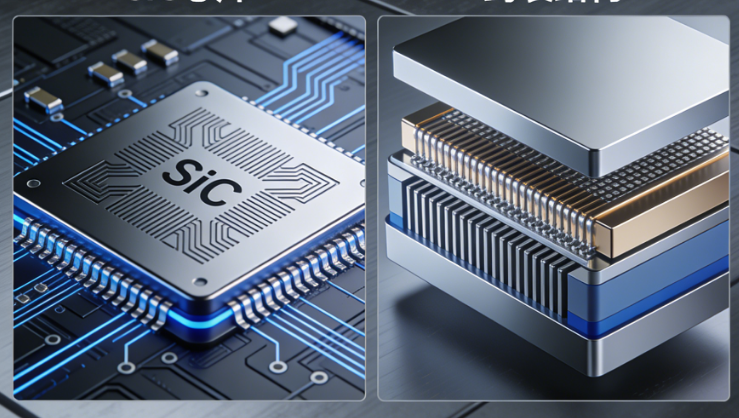

SiC功率器件的高温时代:封装成为行业发展核心瓶颈

在半导体功率器件技术迭代进程中,碳化硅(SiC)凭借高温工作、高电流密度、高频开关的核心优势,成为推动功率半导体升级的关键方向,其普及大幅提升了器件的功率密度与工作效率,为功率半导体行业发展带来全新机遇。但与此同时,行业发展的核心瓶颈正悄然从芯片设计与制造环节,转移至封装层面。当SiC将功率器件的工作温度与功率密度不断推高,芯片本身已具备承受更高应力的能力,而封装环节的材料适配、热路径设计等问题却日益凸显,高温与快速功率循环叠加的工况下,焊料与热路径成为决定SiC功率模块寿命的核心因素,封装技术的发展水平,正成为制约SiC功率器件产业化落地与长期可靠应用的关键。

2026-02-12